Szybkość indeksacji podstron serwisu, czyli liczba stron odwiedzanych dziennie przez roboty Google, ma związek z tym, czy wyszukiwarka potrafi skutecznie odnaleźć wszystkie podstrony dostępne w obrębie danej witryny. Ma to duże znaczenie przede wszystkim w przypadku rozbudowanych serwisów, gdzie codziennie pojawiają się setki czy tysiące nowych treści.

Liczba stron indeksowanych każdego dnia zależy od wielu czynników. Należą do nich: nawigacja wewnętrzna i architektura informacji w serwisie, PageRank strony, liczba i jakość linków zewnętrznych prowadzących do domeny i podstron serwisu, częstotliwość zmian na stronie itd. Tutaj chcielibyśmy zwrócić uwagę na dwa czynniki, które bywają często niedoceniane i pomijane podczas optymalizacji serwisów internetowych.

Pierwszym jest szybkość ładowania strony – czyli po prostu to, ile czasu roboty Google muszą poświęcić na pobranie każdej podstrony serwisu. Oficjalne informacje i spekulacje na ten temat zaczęły pojawiać się kilka miesięcy temu. Matt Cutts już w październiku 2009 roku mówił o szybkości ładowania stron jako o jednym z ważniejszych czynników wpływających na pozycjonowanie.

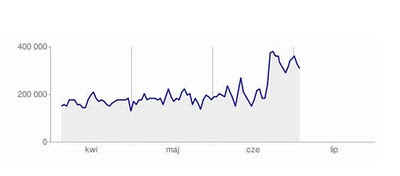

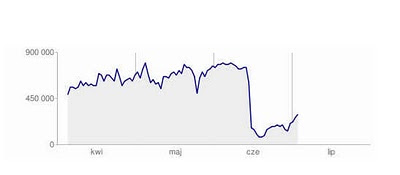

W tym artykule prezentujemy wpływ wprowadzenia kompresji gzip na liczbę stron pobieranych dziennie przez roboty Google. Na dużym serwisie e-commerce kompresja gzip została wprowadzona w drugiej połowie czerwca. Jak widać, liczba kilobajtów pobieranych dziennie od razu spadła o dwie trzecie…

Drugim sposobem na poprawę szybkości indeksacji jest manualne ustawienie maksymalnych limitów szybkości indeksowania podstron w ustawieniach narzędzi Google Webmaster Tools.

—

Redakcja